Hogyan hozzunk létre robotok txt fájl wordpress megjegyzi webmaster

Ez a cikk fog beszélni blogja optimalizálásához robots.txt fájl segítségével, élező, hogy a keresőmotorok, és hogy miért van szükség erre.

Hogyan hozzunk létre robotok txt a WordPress?

Nem titok, hogy több mint 70-80% -át a forgalom a honlapunkon jön a keresési vagy a keresők (PS).

Sokan közületek, akik a saját személyes blogok vagy honlapok írni őket érdekes cikkeket. így próbálják segíteni az embereknek megoldani a közvetlen problémákat egy adott területen.

Egyes bloggerek azt mondják, hogy nem kell optimalizálni oldala (”... miért ez a robotok txt? ...»), és az a tény, hogy jön a sok embert, mert van egy egyedi cikket ...

Hogyan hozzunk létre Robots txt

Robotok telepíti a fájlt a WordPress blog, és ezáltal növeljék a látogatók az SS saját források!

Az a tény, hogy a könyvtár Wordpres s rendszer egy csomó támogatást scriptek, oldalak, fájlok, amelyek egyszerűen be kell zárni az indexelő robotok.

A legfontosabb jellemzője Robots txt a WordPress, hogy gyökerét a blog, és azt mondják ki az összes lehetőséget keresők, ami azt jelzi, hogy az indexelni kívánt egy blogot, és mi nem.

Most hozza létre a fájlt, regisztrálja, és állítsa be a kívánt beállításokat a blogunkon. Hozzon létre egy robots.txt WordPress két módja van:

A plugin neve «KB Robots.txt». Ez nagyon egyszerű, és a beállítások oldalon csak egy ablak a formában, amelyben és annak szükségességét, hogy az összes szükséges paramétert (lásd alább), majd nyomja meg a gombot «Submit» menteni.

Itt van az én verzióm a robots.txt fájlt a blogomban:

Problémák indexelése blogja

Ebben az esetben, ha a helyszínen nem szükséges bővítményt, hogy a hivatkozások CNC. ott lehet a probléma indexelésekor oldalakon.

Sort a robots.txt fájlban:

Csak tiltják indexelés oldalak az ilyen típusú. Ezért a problémák elkerülése érdekében azt javasoljuk, hogy menjen a fenti linkre, és testre a CNC linkeket a blog.

Mint látható, nem használja a Google robot tilalmat tiltása :? / * * A robots.txt, és nem tanácsot. Csak Yandex!

Így ezek az ismétlődő oldalakat, akkor számtalan a SERPs, mint a Google. Ez maga után vonná az engedélyét a kereső.

Akkor már túl késő lesz, hogy panaszkodnak, hogy a blog nem tudja mászni a legjobb pozíciókban, és hogy a forgalom esett több alkalommal.

Ehhez menjen át az FTP gyökér mappát, majd nyissa meg a blog, hogy módosítsa a .htaccess fájlt. Akkor ezt tegye meg a következő szavakkal van:

Ez minden. Most, ha a robot mozog a duplikált oldalt, azonnal átirányítja a főoldalon.

Helyes robotok txt

By the way, ez a változat a robots.txt fájl nem a végső igazság. De ez a helyes robots.txt .I hiszem.

Ez annak a ténynek köszönhető, hogy sok vélemény helyességéről és célszerűségét írásban vagy sem, az egyes irányelvek a fájlt.

A határozott válasz erre a kérdésre csak akkor lehet PS programozók.

Itt vannak a legfontosabb eredmény, és az eredmény az adott pillanatban a következő:

- A testület a Google és Yandex webmaster nincsenek hibák és észrevételek a robots.txt fájlt

Megjegyzem, hogy a munkám fájlt. Azt ellenőrizték ezt sokszor, ellenőrzést végző blog különféle szolgáltatásokat.

És most még egy trükk tőlem. Ha van egy bloggal fiatal, de ez nem feltétlenül szükséges, de természetesen a jövőben hasznos.

Megszabadulni a terhelés a szerveren

Arról beszélek, hogy a megnövekedett terhelést a szerveren, ha fürkésző blogkereső robot. Ahhoz, hogy megszabaduljon, akkor regisztrálnia kell a robots.txt fájlban irányelv csúszás késés.

Legyen elég könnyű. Felírni érték Crawl-delay: 10 után tiltása értékek engedélyezése.

Frissítve robotok txt a WordPress.

Barátok, és most nagyon fontos információkat! Ha megnézzük a robotok txt fájl, akkor látni fogja, hogy nem hasonlít az egyik, hogy azt sugallják, hogy telepítse a blog korábban ebben a cikkben. És mindezt azért, mert sajnos nem működik.

Igen, igen, jól hallottad. Nem működik! Az a tény, hogy ő valójában nem tiltják az indexelés olyan témák, mint a címke, Oldal, takarmány, mellékletet, megjegyzés oldalas, trackback és kategóriában. Ez ahhoz vezet, hogy a megjelenése ismétlődő oldalakat, hogy van, ugyanazzal a tartalommal. És megduplázza az oldalakat, viszont ahhoz vezethet, hogy a szűrőket a keresőmotorok.

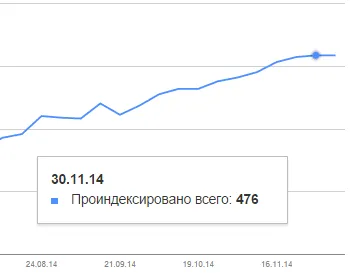

Ez a „csorda” jegyezte tisztelt blogger Alexander Borisov, és azt mondta róla egy cikket a blogján isif-life.ru. Döbbenetes volt, hogy sok blogger. Az eredmények néhány tízezer oldalak páros. A blogom is esett a forgalmazás. Nézd meg, mennyi van oldalt a Google indexében:

És annak ellenére, hogy én írtam a 98 cikket! 476-98 = 378 oldalak-vesz. Huhh ... Szerencsém volt ...

De a helyzet a blogomban változások, az ütemezés már stabilizálódott, és hamarosan ezek az ismétlődő oldalakat lesz kevesebb és kevesebb! Hála Alexander a segítséget!

Ezért el kell olvasni a cikket Aleksandra Borisova isif-life.ru blog, hogyan kell eltávolítani ismétlődő ezeket az oldalakat. De merem állítani, hogy nem minden az információkat a cikkben.

By the way, azt ajánlom, hogy olvassa el a cikket mikrorazmetke. Ez egy nagyon fontos téma, és nagy segítséget előmozdítása a blog!

Sok szerencsét és sok sikert Üdvözlettel,

További érdekes cikkek:

A könyv arról szól, jövedelem az interneten:

Szergej, van még néhány kérdést, de nem tudja, mit cikket érdemesebb kérni, ezért úgy vélem, hogy nem lesz több releváns.

Lásd például index oldal jelenik meg a Google (alább). Kérdései vannak:

1 Do kell ezeket az oldalakat az index?

2. Ha a „nem”, mind a közeli otindeksatsii a robots.tht vagy valami más?

Basil, az első kérdésem, hogy ha „beállította a CNC linkeket a blog?”

Igen, a CNC van kialakítva, az alábbiak szerint:

Beállítások - Általános beállítások - Permalinks - Random - /% category% /% postname% /