Hogyan lehet a robotok txt fájl - ingyen webhelyről

Helyes robotok txt - az egyik csúcspontja a kereső optimalizálás. Elő kell mozdítani a webhely a tetején.

Az egyik funkciója a fájl tilalom indexelése összes extra oldalakon a blog.

Keresők egy és ugyanazt a webes erőforrás a www és nem www érzékelni, mint más oldalakon. Megállapította, hogy azok tartalma nem különbözik keresők „beragad” oldalakra.

Ennek elkerülése érdekében javasoljuk, hogy azonosítsák a fő tükör a robots.txt fájlban.

Mielőtt a helyszínen

Költözése után a helyszínen

Tehát a saját honlapján fő tükör - www nélkül. Remélhetőleg jól magyarázható.

Példa egy megfelelő robots.txt az oldalamon a WordPress

Ebben a fájlban az indexelést zárva az összes szakaszok figyelmen kívül kell hagyni a keresőmotorok.

- Mindez szükséges regisztrálni egy szöveges dokumentumot a .txt kiterjesztést, hogy van, hogy a fájl nevét robots.txt. Csak ne felejtsük el, hogy változtatni seitostroenie.ru adatokat a honlapján.

- Ezután ezt a fájlt kell helyezni a gyökér a blog, ugyanabban a mappában, ahol a wp-content.

Most tekintsünk részletesebben értelmében egy dokumentum, az egyes sorokban.

User-agent: * - a szabályok megalkotását az összes keresők;

User-agent: Yandex - Yandex számára;

Megtagadja a hozzáférést a partíciókat robotok:

Állítsa be az elsődleges tükör blog előírja:

Problémák indexelés

Ha a webhely nincs beállítva az NC, indexált lehet a probléma:

Húr - tiltása :? / * * Bezárja indexelni ezeket az oldalakat linkeket ezen állásokra megjelenni, mint ez: site.ru/?p=665.

Ennek kijavításához távolítsa el ezeket a sorokat.

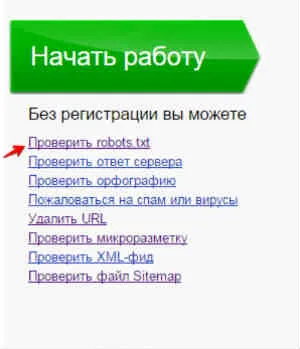

A robots.txt ellenőrzése

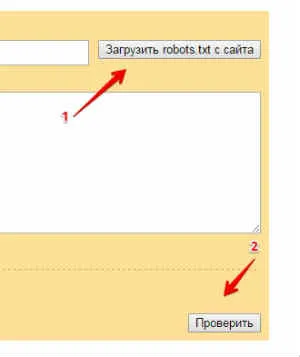

és kattintson a „Feltöltés robots.txt a site”, a következő üzenet jelenik meg:

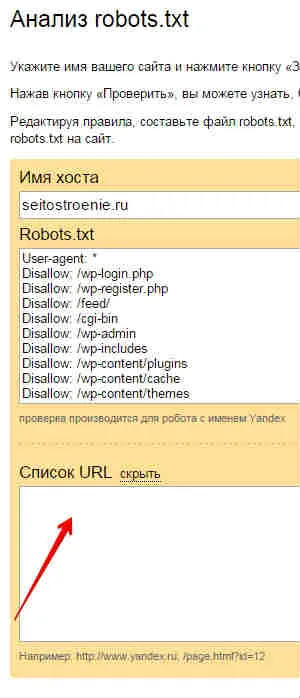

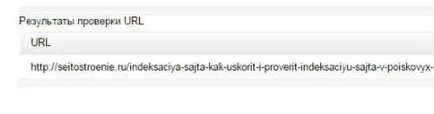

Azt az eredményt kapjuk, hogy minden rendben van:

Mert Runet a leggyakoribb feladat az, hogy hozzon létre egy robots.txt fájlt Yandex. mint most, Yandex - a legnépszerűbb kereső. Fontos, hogy képes legyen használni a fogadó irányelv helyes. amelyek megfelelnek a kereső.

Beküldésével bármilyen formában az oldalon, Ön vállalja, hogy a Privacy Policy

Csak szöveg használata az aktív link a forrás