Hogyan zárjuk az oldalon a keresőprogramok az összes ismert módszerek - Webline promóciós

Ahhoz, hogy minden oldalon megjelentek a keresési eredményeket, akkor elő kell indexelni, hogy feltérképezi a keresőmotor pókok. A következő lépés - a rangsorban - a meghatározása a forrás hely a kérdés. Ez befolyásolja a számos kritérium, melyek közül a legfontosabb -, hogy milyen mértékben az eredmények a kibocsátás a felhasználó kérésére. Oldalon, hogy több releváns, szükséges szabályozni a mozgását és viselkedését a keresési robot rajta. Általános szabály, hogy a keresőprogramok és elrejtése oldalszámozás, szűrők, a szolgáltatás és a tartalmazó oldalakat a felhasználók személyes adatainak. Ebben a cikkben fogjuk vizsgálni az összes ismert módon zárja a dokumentumot a keresők, és fejtse ki, milyen hasznos lehet mindegyik.

robots.txt

A leggyakoribb módja, hogy adjon meg egy keresési oldal robotok bemutatott, vagy éppen ellenkezőleg, zárt, hogy nézze meg a robots.txt. Ez egy egyszerű szöveges fájl található a gyökér könyvtárat a internetes forrás, amely leírja az utasításokat a keresőrobotok.

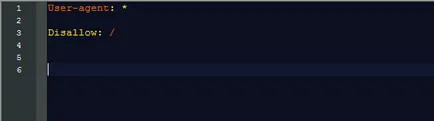

Azonnal bezáródik az egész oldal indexelését, akkor regisztrálnia kell a robots.txt fájlban csak két sort:

Ebben a kézikönyvben, akkor jelentenie kell, hogy valamennyi keresők (User-agent: *); második sor (Disallow: /) azt jelenti, hogy a tilalom vonatkozik minden oldalt az oldal.

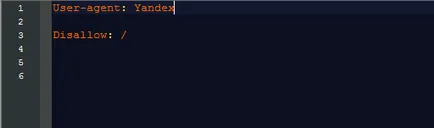

Ha szükséges, zárja be az erőforrás csak egy kereső van a sorban User-agent: adja milyen volt. Gyakrabban, mint az előírt keresők Yandex és a Google:

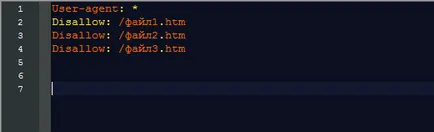

Tiltása vonal is tartalmazhatnak utasításokat az egyes részek, fejezetek vagy telek mappák, amelyek nem kívánatosak feltérképezéséhez robotok.

Letiltani indexelés:

- adott mappát -, hogy ezt a csapatot Disallow: / mappa /;

- Fájl lista - adja meg a teljes listát a következő formátumban:

Meg kell jegyezni, hogy a robots.txt érzékelik a keresők különböző módon, és a Google robotok nem mindig követik az utasításait, észrevette a fájl tartalmát, mint egy ajánlást.

Robotok meta tag regisztrálja a tag html-dokumentumokat, azt a következő értékeket:

A működési elve ilyen meta tagek ugyanaz, mint a robots.txt. Az egyetlen kivétel - azokat közvetlenül az oldalak le kell zárni. Ha beszélünk minden erőforrás adatcímkéket előírt közvetlenül a honlap sablon. Példa a meta robotok:

Ez azt mondja, hogy a robot tilos index az oldalakat, és kap linkeket.

Íme néhány hasznos címkék:

- meta name = »robotok» content = »noimageindex» - megtiltja az index oldalon található képek, amelyeken használják;

- meta name = »robotok» content = »nincs» - értjük «NOINDEX, nofollow».

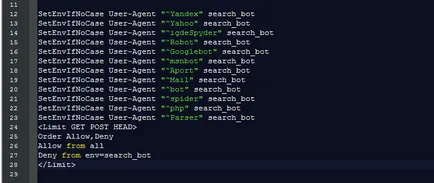

.htaccess fájlt

- Zár a keresőrobotok a következő parancsokat:

Minden kereső - külön sorban.

- Férhessenek hozzá az összes fájl és könyvtár:

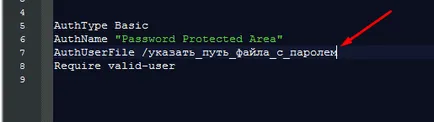

- Korlátozza a jelszót, hogy belépjen az oldalt, vagy oldalra. Ehhez tegye ezt a .htaccess fájlba az alábbi kódot:

Azt jelenti, hogy a tulajdonosok WordPress oldalakon

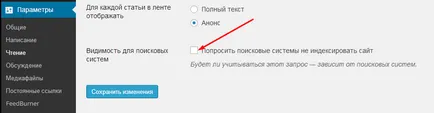

Ha történetesen a tulajdonos a forrás a WordPress, bezárhatja a webhely indexelt segítségével a rendszergazda is, miután csak néhány kattintás:

- Az admin menüből, menjen a Beállítások lapra;

- Válassza Reading;

- jelölje meg azt a pontot a „Kérdezze keresők nem index az oldalon”;

- A változtatások mentéséhez.

Van még néhány SEO-inek, például «All in One SEO Pack», amivel szabályozhatja az indexelés bizonyos dokumentumokat a helyszínen.

Más CMS is lehetnek hasonló jellemzőkkel és plug-inek.

Bármelyiket is választotta az utat a záró az indexelés, ne feledje, hogy a legmegbízhatóbb eszköz kapok az index -, hogy tartsa a helyén a szerver bontja a kapcsolatot a World Wide Web.

- Ahhoz, hogy minden oldalon megjelentek a keresési eredményeket, akkor elő kell indexelni, hogy feltérképezi a keresőmotor pókok. A következő lépés - a rangsorban - a meghatározása a forrás hely a kérdés. Ez befolyásolja a számos kritérium, melyek közül a legfontosabb -, hogy milyen mértékben az eredmények a kibocsátás a felhasználó kérésére. Oldalon, hogy több releváns, szükséges, hogy szabályozza a mozgás és ...