Tippek helyes használata a fájl - devaka seo blog

Egyik tweet, megemlítettem, hogy a robots.txt gonosz és mi ez, annál kárt hozza a helyszínre. Szembesülve sok zavart, beleértve a pillanat, amikor a vélemények megoszlanak optimalizálókkal egyértelmű ebben a kérdésben, amikor néhány webmesterek a régi ajánlások, azt akarom, hogy valamiféle egyértelmű a használata a fájl a jelenlegi környezetben.

Nyilvánvaló, hogy a különböző irányelvek használják robots.txt. Közülük sok hasznos:

Van is egy tiltása irányelv (és engedélyezése az ellenkezője). Ez róluk, és lesz szó ebben a cikkben.

Melyek a problémáit webmesterek a robots.txt használatával?

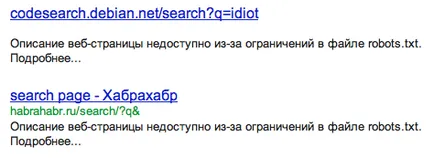

Az első és legfontosabb probléma, amellyel a webmesterek, a jelenléte a Google index oldalak zártak robots.txt. Úgy véljük, hogy ha bezárja egy oldalt vagy szakaszt robots.txt, akkor nem esik az index, vagy dobja ki belőle, ha volt. Ez az, ami jól működik Yandex, Google robots.txt érzékeli másképp.

Hogy lezárja a ismétlődő oldalak jobb kihasználása CMS hazai jogorvoslati lehetőségeket. és nem próbálja meg, hogy az élet könnyebb a robots.txt. Sőt, hogy a fájl, bármilyen okból, hogy nem elérhető (átkerült a másik szerverre, elfelejtett, átnevezték, és így tovább), és ebben az esetben az összes zárt élesen nyitottá válik (talán mint abban az esetben a korábbi szivárgás wiki.yandex-team .ru).

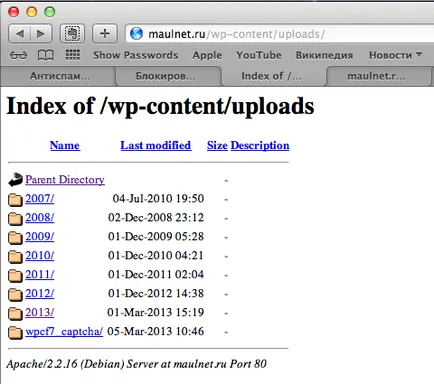

Másodszor, a záró mindent, akkor véletlenül bezárja a fontos dolgokat. Például a záró WordPress egész mappát / wp-content /. Akkor továbbra is anélkül forgalom tárolt képeket a / wp-content / feltöltések /.

Itt tárolják a képet, de a kép, hogy nem keres:

Így kiderül, jobb, ha nem használja a robots.txt? Egyes esetekben még mindig hasznos (különösen, ha írunk az elsődleges tükör Yandex).

Amit ajánlani a robots.txt használatával

- Ahhoz, hogy zárja be a teljes webhelyet a fejlesztés során

Ahhoz, hogy előre az index nem kapott semmi több. - Ahhoz, hogy zárja be a helyszínen a keresőprogramok maradt.

Például a RuNet oldalakon nincs értelme megmutatni a Yahoo! Ha a kereső nem a célközönség, nyugodtan zárja be az oldalon, hogy ne újabb terhet a szervereket. - Hogy lezárja a privát részeit az oldalon a szem a robot.

Ahhoz, hogy a személyes adatok (például hitelkártya-számokat vagy jelszavakat 🙂 SMSes felhasználó) nem tartoznak az index. Bár logikusan ezek a szakaszok nem kell megnyitni az oldalt. - Ahhoz, hogy távolítsa el a terhelés a szerveren

Ha például a nagyon népszerű helyén sok funkcionális sotrirovke árut, vagy olyan szűrők, amelyek több szerver erőforrások, akkor nem hagyja, hogy a robot ezeket az oldalakat, hogy a súlyt. Bár ismét belépés tenné rendezési funkció láthatatlan a robot maga CMS. mint a felelősség áthárítása a robots.txt fájlt.

Amit nem javasoljuk a robots.txt

- Hogy lezárja a indexoldalak lapozás, rendezés, keresés

Tól ismétli meg kell semmisíteni CMS eszközöket. így például, 301 átirányítás. tag rel = kanonikus (ami speciálisan erre a célra hozták létre), 404-es vagy meta tag robotok NOINDEX. - Törölje a meglévő oldalak az index

Gyakori hiba a webmesterek, amikor megpróbálják eltávolítani a lapot az indexből robotok. A bejáró nem lesz képes újra index az oldalt, és törölje, ha közel az ahhoz való hozzáférés révén a robotok. - Bezárásához az admin felületen

admin útvonal látható a robotok. Tehát Optimization.by konferencia, kollégáim és rosszindulatúan hozzáférjen egyetlen honlapon admin a tanfolyam, az útvonalat, ahova tanult egy robots.txt és jelszavak voltak szabvány admin: admin. - Ahhoz, hogy zárja be a másik oldalt, hogy nem akarja látni az index

Bármilyen más módszerek

SEO-elemző, tanácsadó. Mindig lépést az új trendek a SEO piacon.

„Ha a kereső nem a célközönség, nyugodtan zárja be az oldalon, hogy ne újabb terhet a szervereket.”

Ha a terhelés félni a látogatók száma néhány kereső - ez mennyit kell menni az emberek ennek a kereső az oldalon néhány kérést? Ebben az esetben, az emberek iránt érdeklődő kulcsszavakat, de az oldalon nem érdekli ezeket az embereket?

Yan. ha az emberek jó. A lényeg az, hogy a kereső első indexek az oldalon. És egy ideig Yahoo! indexelt nagyon agresszíven, néha elment a szerver. Ezért felér egy irányelv csúszás késleltetés. Itt leírás inkább technikai kérdés, nem a felhasználó.

Értem helyesen a rel = „kanonikus”?

1. Ha egy blognak 100 oldal, milyen primer de a régebbi hozzászólások, minden oldalon (oldal 1, 2, 3) nem lehet az URL-link a főoldalon, és a fő is?

Vagy csak ad egy URL-t a fő, hogy maga és az egész olyan, mint te?

2. Csak azt nem értem, hogy ez a REL Canonical.

Például: Van egy 20 oldalas, minden mutató link rel és a Canonical URL 1 oldalt. A Google esetében ez azt jelenti, hogy az index kell csak 1 oldalon? Jobb?

de talán a robots.txt nem szükséges előírni a gazda, aki nem tudja a gazda az elsődleges tükör helyén, itt vagyok egyszer nem regisztrált, és már a helyszínen indexelt egy másik tükör

És meg tudná mondani a segítségével a csapat is blokkolja a hozzáférést bizonyos álláshelyek helyszínen történő indexelést a bejárat és a látogatók (lenne csak a rendszergazda)

Azt mondják, hogy a robots.txt használata rossz, mert lehet, hogy bajt következtében saját ostobasága - ez érthető. A második kulcs mínusz robots.txt - Google még indexek. Jól gondolom, hogy elfog a lényege a hátulütői robotok?

Kezdve ezeket a hátrányokat, én megszűnik megérteni további következtetések a cikkben.

1. ajánlani használatra robots.txt zárja indexelésével saját információs oldal (például lapok műanyag kártya számát). Tehát mivel a Google index mindegy?

Olvastam, és úgy döntött, hogy a legjobb nem is nyúlt hozzá. Hogyan lehet így legyen. És hogyan nem lett rosszabb.

Ha vannak olyan törött linkek, hogy jobb, ha nem? Írja őket a robots.txt a Disallow vagy várjon indexelés? A Google és Yandex csökkenti értékelés a hibás linkeket?

Amit nem zárja be, attribútumok, és egyéb modulokat. Játszunk a pályán és canids saját szabályaik. Yasha - a tulajdonos a forrás, és ez jobb, ha nem mutatnak túl sokat, és ebben az esetben (aka kereső), és büntetni. Én egy ellenséges - rátát és a linkeket a zárt hírhedt attribútumot. Legutóbb, valamilyen oknál fogva, akkor kezdődött megjelenő Bekah JMM. Az egész kódot mindkét oldalak - tárhelyszolgáltatóval nem takarítják nofollou. Röviden kutya pofigu fér hozzá, nofolou, noindeks és mások. Pofigu yuzverg, ő hozza a pénzt mindannyiunk számára, és neki!

El kell játszani, őszintén, mert nem lesz képes legyőzni a priori!

Robots.txt nézett a webhelyen. Ez némileg eltér, hogy mivel a cikkben. Megértem, hogy a hely semmit sem ér. Változások fordulhat elő, ha jelentős, és mikor nem.

Én leginkább érdekelt a tag közeli vagy sem zárja?

Hmm ... Mondja, yukoz elmondja mindenkinek, hogy ő robots.txt hangolt tökéletesen, hogy igaz-e, vagy ez mindegy kell szerkeszteni.

Ön használatát javasoljuk robots.txt zárja indexelés saját információs oldal (például lapok műanyag kártya számát). Tehát mivel a Google index mindegy?

Vannak olyan oldalak, amelyek nem kap senki kívülről (linkek nélkül), kivéve a személyes adatokat a tulajdonos. Ha ezek az oldalak nem zárt, akkor indexelt keresők (mint ahogy az a MegaFon olyan, mint ha eszébe ezeket szétszerelés).

Végtére is, referenciaként rel = „kanonikus” csak egy oldalt szinte teljesen azonos tartalommal. Amikor lapozás a második oldalon lesz valami egészen más, mint az első.

Igen, igazad van, az oldal más lesz, de még mindig a Canonical lehet használni, és az ilyen esetekben, hogy működni fog. A másik dolog az, hogy néhány nappal ezelőtt a Google nem ajánlott használni ezt a címkét lapozás, igen. címkék helyett kínál rel = prev és rel = next.

Ha vannak olyan törött linkek, hogy jobb, ha nem? Írja őket a robots.txt a Disallow vagy várjon indexelés? A Google és Yandex csökkenti értékelés a hibás linkeket?

Törött linkek a webhely vagy a tiéd? Általában a legjobb, ha a kapcsolatot a webmaster, és megszakadt kapcsolatok nem sérült. Ha ez nem lehetséges, akkor létre saját CMS (vagy kiszolgáló) denevér linkre leadott hasznos információt (legalábbis 404 oldal egy gazdag kínálata egyéb lehetőségek oldalakon).

Én leginkább érdekelt a tag közeli vagy sem zárja?

Ha ezek az oldalak nem hozzáadott értéket a helyszínen (kivéve navigáció), még csak nem is szoros, és távolítsa el az oldalról. De IMHO.

Yukoz elmondja mindenkinek, hogy ő robots.txt hangolt tökéletesen, hogy igaz-e, vagy ez mindegy kell szerkeszteni.

Itt nem kérdez uCoz nem működött. Mindenesetre, érdemes megnézni, hogy minden, amit beállítva.

Kedves Sergey, nagyon köszönöm a cikket. Te csak finom, persze ... A kérdésem: Van egy Word Press honlapján közvetlenül a házigazdája, azaz Nem használja a helyi szervert Denver „próbák”. Ezért hoztam létre egy aldomain testiruem.imya oldalon. Hogyan érhetem el, hogy a „láthatatlan” a keresők? Használhatja a robots.txt? Köszönöm szépen előre

Mivel a keresők kapott =), hogy őszinte legyek - mindig valami lapáttal perefiltrovovayut, nem lett leült, és megállapodtak abban, hogy együtt dolgozik egy közös szabvány -, hogy minden van egy szett, és ők voltak az egységes szabvány!

Itt találkozott a kijelentés, hogy a robots.txt irányelvek jogilag kötelező axiómaként. De ez nem igaz! Zárva a helyszínen a robots.txt első könyvtárak, amelyek nem igényelnek indexelést, akkor az egyes oldalak, amelyek már net.Bespolezno! Újabb apa még nem létező oldalak lógott a keresést.

Csak miután érintkezésbe visszajelzést Platos schutskiny azt mondta, hogy meg fog tenni semmit. Először is, az összes szokásos válasz, akkor írásban formában a Yandex. És csak ezek után nem létező oldalak eltűntek.

Tehát Yandex legalábbis nem mindig engedelmeskedik az irányelvek ...

„Ahhoz, hogy zárja be a indexoldalak lapozás, rendezés, keresés

Tól ismétli meg kell semmisíteni CMS eszközöket. például, a 301-es átirányítás, tag rel = kanonikus (amely speciálisan erre a célra hozták létre), 404-es vagy meta tag robotok noindex. "

Kérem, mondja, hogyan lehet megoldani a problémát az a tény, hogy a fő blog oldalt vezethet különböző linkeket. Például, egy fél www. és fél www nélkül. Ez kedvezőtlenül befolyásolhatja a rangsorban elfoglalt hely?

Sergey, jó napot.

Ma hívta fel a figyelmet, hogy a rivális, több mint egy éve 1-jén sor Yandex.

a leghosszabb ilyen robot.txt a Yandex és Google, valószínűleg 50-100 vonalak.

Mit gondol ez fontos a kérdés?

Szergej, és akkor csak írj egy pár oldalt itt? Szeretném, hogy a területet közelről az ideális állapot. Május elején, hogy rögzítse a mobil verzió, és lesz tisztességes. Egy részlet minden tengeren.

mebelona.ru/mebel/krovati/ és mebelona.ru/tip_mebeli/krovati/

Nem tudom valahogy meggyőzni a fejlesztő, hogy az átirányítás a fő tükör www. 🙂

Köszönöm szépen, Szergej! Másolás a választ, hogy a fejlesztő. Azt htaccess, hogy ő nem mertek mászni. Slazit alkalommal már. ))

Üdvözlünk! Mondd, kérlek, egy pillanatra.

Ha teljesen zárt már a keresés és az index olyan helyet a kiadatási kivonatok megjelennek mondatok a la „A webhely zárva indexelés.” Tudok valahogy elkerülni? Legyen úgy, hogy még a zárás után az indexelő töredék maradt.

Jó napot kívánok.

Azt is ugyanaz a probléma, mint a Makar, csak én még nem keresett a helyszínen minden kereső :(.

Kezdetben én is nem konfigurált robots.txt, de aztán, és ezt hozzáadjuk a site map.

Adagolás után megpróbált keresztül webmaster panel a Google és Yandex.

De sem a kész nem hozta meg a találatok :(. A honlapot a lekérdezéseket a Google és Yandex nem :(.

Mondd, mi mást lehet az oka, és ha ásni?